Diffusion Probabilistic Models

Proyecto computacional, pregrado Física. Universidad de los Andes (2023)

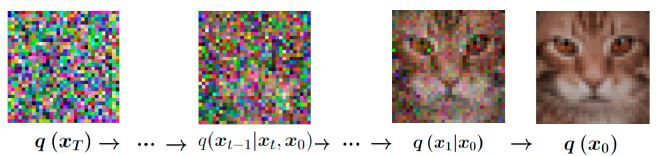

En el ámbito del aprendizaje automático los modelos probabilísticos de difusión han surgido como una destacada categoría de modelos generativos. Su objetivo principal es aprender un proceso de difusión que describa la distribución de probabilidad de un conjunto de datos dado. Este enfoque se compone principalmente de dos elementos clave: forward process y backward process. Estos modelos se aplican con éxito a diversas tareas, como el de-noising, el inpainting y la generación de imágenes. Estos modelos han demostrado su versatilidad al generar datos del mundo real, destacando ejemplos notables como generadores de imágenes condicionados por texto, como DALL-E y Stable Diffusion.

La esencia de los modelos generativos basados en difusión encuentra sus raíces en la física estadística, donde la difusión se modela mediante la descripción de la propagación browniana de partículas a través de un sistema físico. Inspirados en estos conceptos, los Diffusion Generative Models toman la noción de difusión como un proceso central. Al comprender cómo las imágenes se difunden en un espacio abstracto, estos modelos capturan patrones inherentes y generan datos sintéticos que reflejan la estructura subyacente de conjuntos de datos reales. Esta conexión con la física estadística proporciona una base teórica sólida para que personas con un cierto conocimiento de física puedan comprender cómo funciona este y otros métodos de Machine Learning, campo que ha tenido un gran desarrollo a lo largo de la última década.

Universidad de los Andes | Vigilada Mineducación

Reconocimiento como Universidad: Decreto 1297 del 30 de mayo de 1964.

Reconocimiento personería jurídica: Resolución 28 del 23 de febrero de 1949 Minjusticia.

Web design and programming © Gabriel Téllez